Bayes es Plural.

La aplicación estricta de las reglas de probabilidad (o enfoque bayesiano) constituye la base de la inteligencia artificial (IA) y las ciencias empíricas (o ciencias con datos) debido a que garantiza creencias óptimas dada la información disponible.

Las reglas de la probabilidad se conocen desde finales del siglo 18 y son conceptualmente intuitivas: preservar la creencia previa que sigue siendo compatible con los datos (regla del producto) y predecir con la contribución de todas las hipótesis (regla de la suma).

Si bien en todo este tiempo no se ha propuesto nada mejor en términos prácticos, su aplicación se ha visto limitada históricamente debido al costo computacional asociado a la evaluación de todo el espacio de hipótesis.

En las vísperas del siglo 21 estos obstáculos han sido superados en parte gracias a los avances computacionales y algorítmicos modernos.

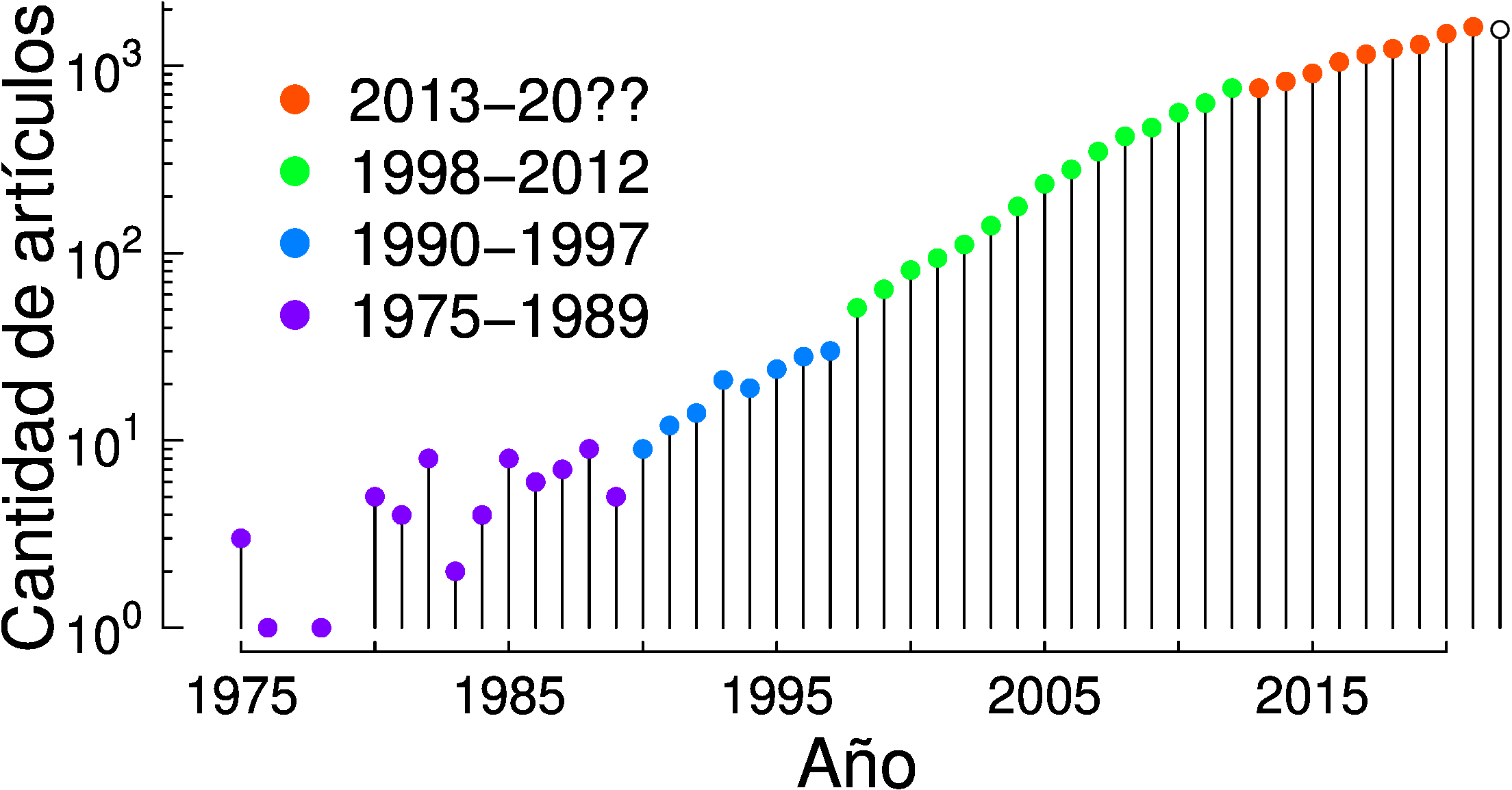

Si bien en la actualidad el crecimiento del enfoque bayesiano es un fenómeno mundial que se está acelerando, la inercia histórica hace que su desarrollo siga siendo incipiente, especialmente en países periféricos.

La relevancia de dichos métodos contrasta con la realidad actual en la que el enfoque bayesiano es todavía marginal incluso en las universidades más importantes de la América Plurinacional, y prácticamente inexistente en ciencias empíricas que no cuentan con formación específica en matemática y programación.

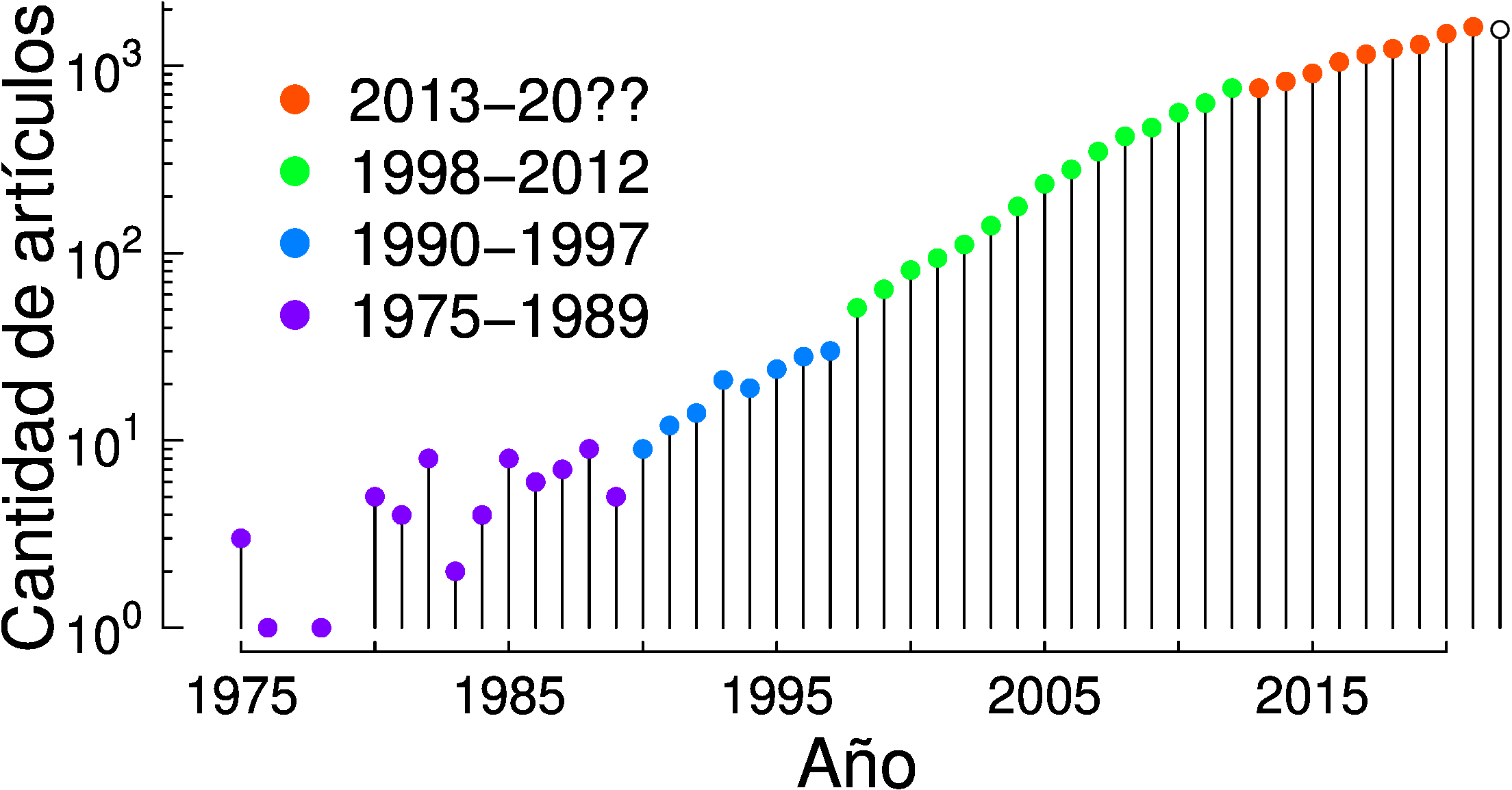

En la siguiente figura se detalla la cantidad de artículos científicos vinculados al enfoque bayesiano publicados cada año con al menos una autoría con filiación en América Plurinacional según Scopus.

A finales de siglo, con el proceso de masificación de las computadoras personales, el enfoque bayesiano comenzó a ocupar el centro de atención de la inteligencia artificial (IA) hasta que en el año 2012 se presenta una red neuronal convolucional profunda entrenada sobre GPU.

Nuevamente la complejidad computacional actuó como un límite a la aplicación estricta de las reglas de la probabilidad, que obligan a evaluar todo el espacio de hipótesis.

Aún así, el auge de las redes neuronales profundas no produjo la aparición de un nuevo sistema de razonamiento bajo incertidumbre con mejor desempeño que el de las reglas de la probabilidad, por lo que el enfoque bayesiano sigue siendo el corazón de la inteligencia artificial y de toda ciencia empírica.

En este contexto, en el marco de la 35 Conferencia Anual de Sistemas de Procesamiento de Información Neuronal (NeurIPS 2021) se realizó una competencia denominada "Approximate inference in Bayesian Deep Learning", donde se confirmó que los deep ensambles son buenas aproximaciones de las redes neuronales bayesianas [1,2].

Encontrar buenas aproximaciones computacionales a la aplicación estricta de las reglas es una etapa necesaria pero no suficiente.

Para explicar el mundo y tomar decisiones en contextos de incertidumbre es necesario proponer teorías causales que predigan el efecto de las intervenciones sobre la realidad [3,4].

Las teorías causales son hipótesis, y como tales pueden ser evaluadas mediante la aplicación estricta de las reglas de la probabilidad [5], P(Teoría causal|Datos), que penaliza naturalmente la complejidad innecesaria de los modelos.

Hoy la inteligencia artificial tiene la oportunidad de hacer uso de los modelos causales que se desarrollan en diversas ciencias empíricas, y las ciencias empíricas tienen la oportunidad de crear y evaluar modelos a la medida de cada problema específico [6].

En este contexto, nuestro objetivo es impulsar la Inteligencia Bayesiana en la América Plurinacional y los pueblos del sur global.

Para que podamos hablar de Inteligencia Bayesiana es necesario que la función de costo utilizada para actualizar las creencias garantice el aprendizaje a partir de la interacción con la realidad.

Este mismo punto ya fue expresado en 1956 por John L Kelly en su artículo "A new interpretation of information rate" [7] aprobado por su colega de laboratorio Claude Shannon:

"The cost function approach [..] can actually be used to analyze nearly any branch of human endeavor. The utility theory of Von Neumann shows us one way to obtain such a cost function. The point here is that an arbitrary combination of a statistical transducer (i.e., a channel) and a cost function does not necessarily constitute a communication system. What can be done, however, is to take some real-life situation which seems to possess the essential features of a communication problem, and to analyze it without the introduction of an arbitrary cost function. The situation which will be chosen here is one in which a gambler uses knowledge of the received symbols of a communication channel in order to make profitable bets on the transmitted symbols."

No casualmente la función de costo de la Teoría de la Probabilidad (el teorema de Bayes) y la función de costo de la Teoría de la Evolución (el replicator dynamic) son isomorfas [8].

En particular, ambas seleccionan a las variantes (las hipótesis o las formas de vida alternativas) siguiendo procesos multiplicativos: por secuencia de predicciones en probabilidad, o por secuencia de tasas de reproducción y supervivencia en evolución.

La naturaleza multiplicativa del proceso de selección es el origen de la Inteligencia Bayesiana y Evolutiva.

Debido a que el impacto de los eventos negativos es más fuerte que el impacto de los eventos positivos (un único cero en la secuencia produce una extinción irreversible), las variantes que emergen son las que reducen las fluctuaciones por diversificación individual, por cooperación, por especialización cooperativa y por heterogeneidad cooperativa [7,9].

Esto se evidencia en nuestra propia vida, que depende de al menos 4 niveles de cooperación con especialización sin los cuales no podríamos sobrevivir [10]: la célula con la mitocondria, el organismo multicelular, la sociedad y el ecosistema.

Lo mismo ocurre con la cultura: las hipótesis elementales se agrupan para formar variables (o espacios de hipótesis), las variables se relacionan entre sí para formar modelos causales, y los sistemas de modelos causales forman las teorías causales.

La palabra Plurinacional representa en Sudamérica la coexistencia de nuestras diversidades culturales locales.

Esta visión es especialmente adecuada para una comunidad que trabaja con métodos bayesianos, que a diferencia de los procedimientos ad-hoc que seleccionan una única hipótesis (e.g. por máxima verosimilitud), aprovecha el valor práctico de considerar toda la pluralidad de hipótesis existentes.

Del mismo modo que seleccionar una única hipótesis tiene consecuencias negativas conocidas en probabilidad (overfitting) [11], la masiva pérdida de la diversidad cultural provocada por la imposición de un único tipo de sociedad durante la colonial-modernidad está teniendo consecuencias biocenóticas y ambientales cada vez más evidentes [12,13].

Del mismo modo que el enfoque bayesiano se adapta a la realidad gracias a que trabaja con hipótesis mutuamente contradictorias, una sociedad plurinacional se adapta a la vida mediante la coexistencia de nuestras diversidades.

Referencias:

[1] Wilson AG, Izmailov P. Bayesian deep learning and a probabilistic perspective of generalization. Advances in neural information processing systems. 2020.

[2] Izmailov P, Vikram S, Hoffman MD, Wilson AGG. What are Bayesian neural network posteriors really like?. International conference on machine learning. 2021.

[3] Pearl J. Causality. Cambridge University Press. 2009.

[4] Peters J, Janzing D, Schölkopf B. Elements of causal inference: foundations and learning algorithms. The MIT Press. 2017

[5] Winn J. Causality with gates. In: Artificial Intelligence and Statistics. Proceedings of Machine Learning Research. 2012.

[6] Bishop CM. Model-based machine learning. Philosophical Transactions of the Royal Society A: Mathematical,Physical and Engineering Sciences. 2013.

[7] Kelly, JL. A new interpretation of information rate. The Bell System Technical Journal. 1956.

[8] Czégel D, Giaffar H, Tenenbaum JB, Szathmáry E. Bayes and Darwin: How replicator populations implement Bayesian computations. Bioessays. 2022.

[9] Peters O. The ergodicity problem in economics. Nature Physics. 2019.

[10] Szathmáry E, Maynard Smith J. The major evolutionary transitions. Nature. 1995.

[11] Bishop CM. Pattern recognition and machine learning. Springer. 2006.

[12] Ostrom E. Governing the commons: The evolution of institutions for collective action. Cambridge university press. 1990.

[13] Segato, RL. La crítica de la colonialidad en ocho ensayos y una antropología por demanda. Prometeo (2013).

La aplicación estricta de las reglas de probabilidad (o enfoque bayesiano) constituye la base de la inteligencia artificial (IA) y las ciencias empíricas (o ciencias con datos) debido a que garantiza creencias óptimas dada la información disponible. Las reglas de la probabilidad se conocen desde finales del siglo 18 y son conceptualmente intuitivas: preservar la creencia previa que sigue siendo compatible con los datos (regla del producto) y predecir con la contribución de todas las hipótesis (regla de la suma). Si bien en todo este tiempo no se ha propuesto nada mejor en términos prácticos, su aplicación se ha visto limitada históricamente debido al costo computacional asociado a la evaluación de todo el espacio de hipótesis. En las vísperas del siglo 21 estos obstáculos han sido superados en parte gracias a los avances computacionales y algorítmicos modernos. Si bien en la actualidad el crecimiento del enfoque bayesiano es un fenómeno mundial que se está acelerando, la inercia histórica hace que su desarrollo siga siendo incipiente, especialmente en países periféricos.

La relevancia de dichos métodos contrasta con la realidad actual en la que el enfoque bayesiano es todavía marginal incluso en las universidades más importantes de la América Plurinacional, y prácticamente inexistente en ciencias empíricas que no cuentan con formación específica en matemática y programación. En la siguiente figura se detalla la cantidad de artículos científicos vinculados al enfoque bayesiano publicados cada año con al menos una autoría con filiación en América Plurinacional según Scopus.